주요 학습 내용 요약

Part3. 내게 필요한 정보를 자동으로 수집 ! with 웹 크롤링

CH02. 크롤링 실습

(2) cURL 명령어로 데이터 크롤링하기 - 네이버 부동산

1. 네이버 부동산 페이지 들어가서 원하는 매물들 띄우고

Network에서 articles?로 시작되는 링크의 cURL 복사하기 (bash)

2. cURL convert사이트로 이동해서 변환된 코드 가져오기

https://curlconverter.com/python/

Convert curl commands to Python

Privacy We do not transmit or record the curl commands you enter or what they're converted to. This is a static website (hosted on GitHub Pages) and the conversion happens entirely in your browser using JavaScript. There is also a VS Code extension and a c

curlconverter.com

curl command에 1번에서 복사한 값 붙여 넣기 -> 밑에 뜨는 거 복사해서 가져오기

3. 챗 GPT한테 코드 주고, 파싱 코드 만들어 달라 명령하기

4. 전체 코드

for 문으로 10개 페이지에서 크롤링해오기

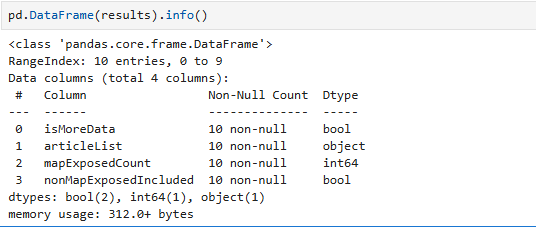

10개의 페이지 데이터들이 리스트로 results에 들어감 (한개의 리스트에 20개의 정보)

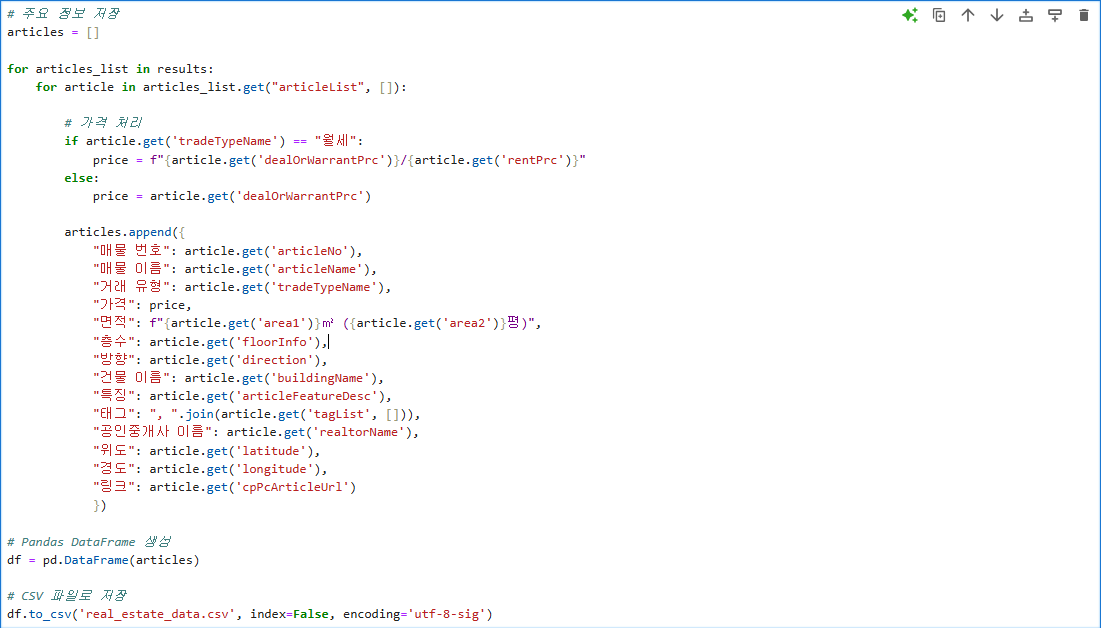

원하는 정보 가져와서 파일 만들기

월세 매물에는 dealOrWarrantPrc 데이터에 보증금만 나와서, rentPrc를 들고와 월세 값을 표시해 줬다.

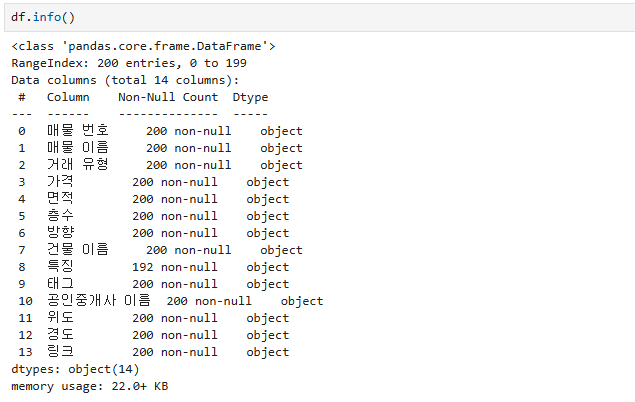

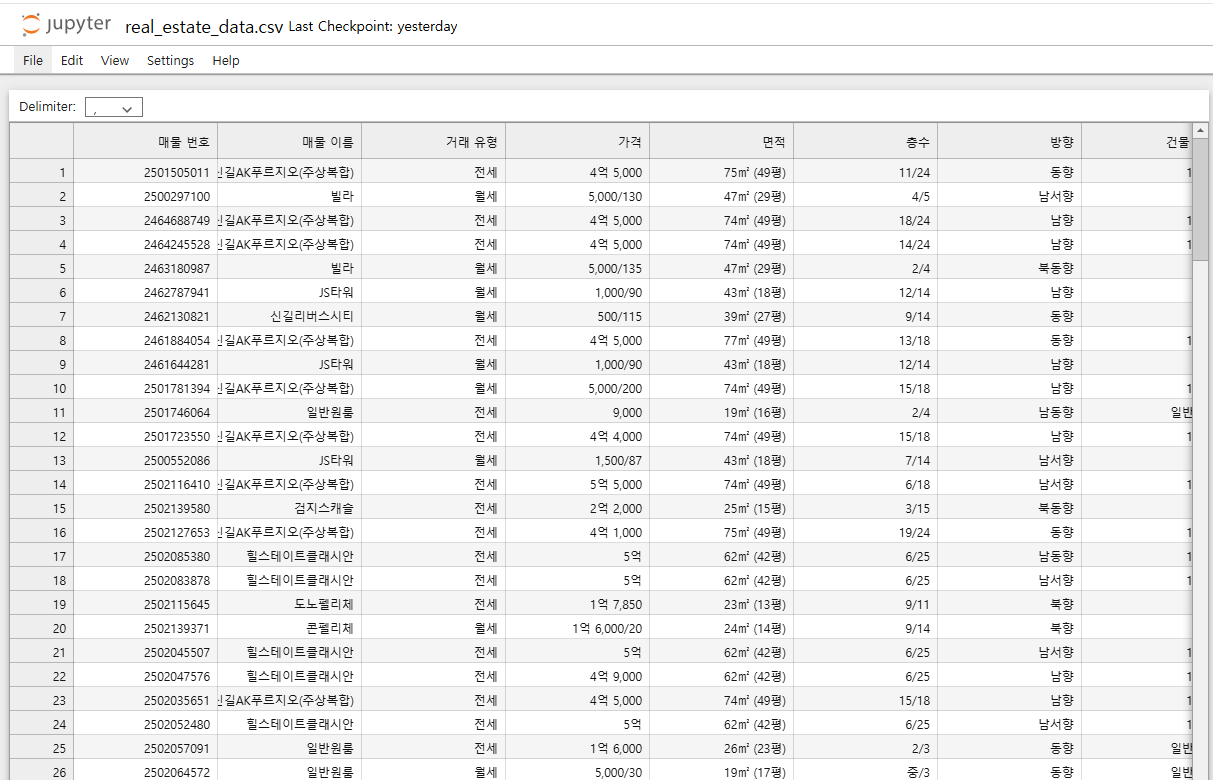

200개 데이터 들고오기 성공

보완할 점

+ 원하는 조건의 매물을 찾는 방법은 온라인 강의실습 과정을 참고

+ 배운 EDA 적용해서 데이터 분석해보기

'패스트캠퍼스' 카테고리의 다른 글

| [패스트캠퍼스] 데이터 분석 부트캠프 17기 - 4주차 (4) pandas (0) | 2025.01.12 |

|---|---|

| [패스트캠퍼스] 데이터 분석 부트캠프 17기 - 4주차 (3) Numpy (0) | 2025.01.12 |

| [패스트캠퍼스] 데이터 분석 부트캠프 17기 - 4주차 (1) 크롤링 실습 셀레늄 (0) | 2025.01.11 |

| [패스트캠퍼스] 데이터 분석 부트캠프 17기 - 3주차 파이썬(4) (0) | 2025.01.04 |

| [패스트캠퍼스] 데이터 분석 부트캠프 17기 - 3주차 파이썬(3) (0) | 2025.01.04 |